[La Guía Definitiva Para El Optimizador Y Editor De Robots.txt Avanzado Y Mejorar Tu Seo]

Resumen Ejecutivo

Este artículo es una guía completa para dominar el archivo robots.txt, un componente esencial para el SEO de cualquier sitio web. Aprenderás a entender su funcionamiento, cómo optimizarlo, las mejores prácticas para su edición y cómo aprovecharlo para mejorar tu posicionamiento en los motores de búsqueda. Este documento te ayudará a comprender cómo este archivo puede mejorar la visibilidad de tu sitio web y su rendimiento en general.

Introducción

El archivo robots.txt es un archivo de texto simple que se coloca en la raíz de tu servidor web y contiene instrucciones para los bots de los motores de búsqueda. Permite a los webmasters controlar qué partes del sitio web son accesibles para los rastreadores, permitiendo que el sitio web se indexe de manera adecuada. Un robots.txt optimizado puede mejorar significativamente tu SEO, al asegurar que los rastreadores de Google y otros motores de búsqueda puedan acceder a las páginas más importantes de tu sitio web, y al mismo tiempo evitar que accedan a secciones no deseadas o irrelevantes.

Preguntas Frecuentes

1. ¿Qué es el archivo robots.txt y por qué es importante?

El archivo robots.txt es un archivo de texto que contiene instrucciones para los robots de los motores de búsqueda, indicando qué páginas pueden o no indexar. Es crucial para el SEO porque permite controlar el acceso de los bots, mejorando la eficiencia del rastreo y la indexación.

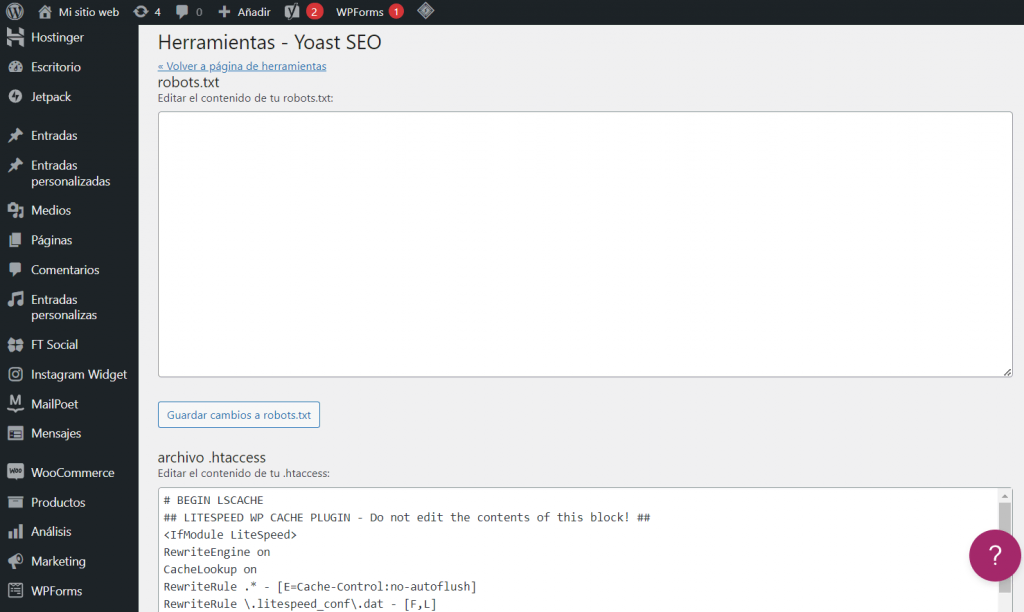

2. ¿Cómo puedo crear o editar el archivo robots.txt?

Puedes crear o editar el archivo robots.txt a través de tu panel de control de alojamiento web o mediante un editor de texto, como Notepad o TextEdit. Solo asegúrate de guardar el archivo como robots.txt y subirlo a la raíz de tu servidor web.

3. ¿Qué sucede si no tengo un archivo robots.txt?

Si no tienes un archivo robots.txt, los bots de los motores de búsqueda podrán rastrear y indexar cualquier página de tu sitio web. Esto puede ser útil, pero también puede conducir a la indexación de contenido no deseado, perjudicando tu SEO.

Entendiendo el Funcionamiento del robots.txt

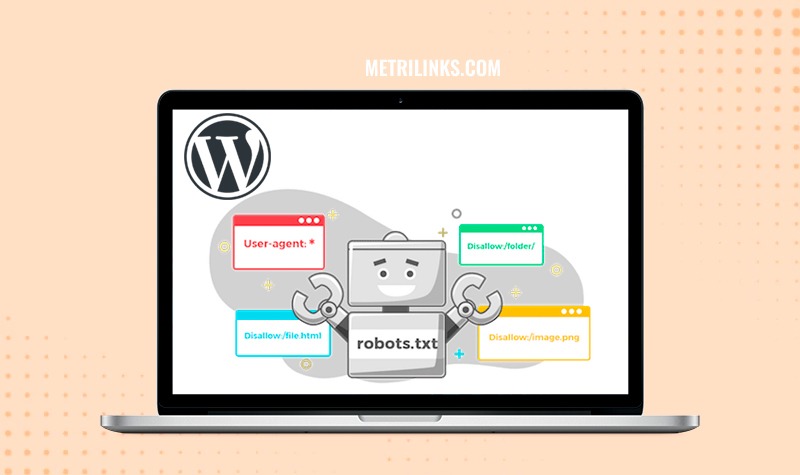

El archivo robots.txt se basa en un lenguaje simple que indica a los bots de los motores de búsqueda qué páginas pueden o no rastrear. Este lenguaje utiliza dos directivas principales:

- User-agent: Especifica el agente de usuario (por ejemplo, Googlebot, Bingbot) al que se aplican las instrucciones.

- Disallow: Indica las rutas o archivos que el agente de usuario no debe rastrear.

Creando un robots.txt Optimizado

Directivas Básicas

- User-agent: Esta directiva define a qué bot se aplica la regla. Por ejemplo, puedes usar

User-agent: Googlebotpara aplicar la regla solo a Googlebot. - Disallow: Indica las páginas o archivos que no deben ser rastreados. Por ejemplo,

Disallow: /admin/impide que Googlebot acceda a la carpeta “admin”. - Allow: Permite acceder a ciertas páginas o archivos. Por ejemplo,

Allow: /blog/permite que Googlebot rastree todos los archivos dentro de la carpeta “blog”. - Sitemap: Especifica la ubicación del mapa del sitio, permitiendo a los bots descubrir fácilmente las páginas de tu sitio web. Por ejemplo,

Sitemap: https://tusitio.com/sitemap.xml

Mejores Prácticas

- Mantén tu archivo robots.txt breve y conciso: Un archivo complejo puede dificultar la comprensión de las reglas por parte de los bots.

- Prioriza el contenido importante: Permite a los bots acceder a tu contenido más importante y valioso, como las páginas de producto o las entradas del blog.

- Evita errores comunes: No bloquee las páginas de búsqueda de tu sitio web, ni las páginas CSS, Javascript o imágenes que son esenciales para la funcionalidad de tu sitio web.

- Prueba tu robots.txt regularmente: Utilizando herramientas como Google Search Console, puedes verificar si tu archivo funciona correctamente y si no bloquea páginas importantes.

Uso Avanzado de robots.txt

Controlar el Rastreo de Archivos y Carpetas

- Bloquear archivos específicos: Puedes bloquear archivos individuales, como archivos PDF o documentos de Word, si no quieres que sean indexados.

- Bloquear carpetas enteras: Si tienes una carpeta específica que no quieres que sea rastreada, puedes usar una directiva

Disallowpara bloquearla completamente. - Bloquear subcarpetas: Puedes bloquear todas las subcarpetas dentro de una carpeta específica utilizando una barra inclinada al final de la ruta. Por ejemplo,

Disallow: /images/bloqueará todas las subcarpetas dentro de la carpeta “images”.

Gestionar la Frecuencia de Rastreo

- Aumentar la frecuencia de rastreo: Si quieres que Googlebot rastree tu sitio web con más frecuencia, puedes incluir una directiva

Crawl-delayen tu archivo robots.txt. - Reducir la frecuencia de rastreo: Si tu servidor web tiene recursos limitados, puedes utilizar la directiva

Crawl-delaypara reducir la frecuencia de rastreo de los bots.

Implementación de robots.txt para SEO

- Optimizar el rastreo: Un archivo robots.txt bien configurado puede ayudar a que los bots de los motores de búsqueda encuentren y indexen las páginas más importantes de tu sitio web de forma eficiente.

- Mejorar la velocidad del sitio: Al bloquear secciones no deseadas de tu sitio web, puedes mejorar la velocidad de carga de las páginas relevantes, lo que beneficia al SEO.

- Prevenir la indexación de contenido no deseado: Puedes utilizar el archivo robots.txt para bloquear el acceso a páginas en desarrollo, contenido duplicado o información confidencial.

- Controlar el acceso a la información confidencial: El archivo robots.txt puede utilizarse para bloquear el acceso a áreas privadas de tu sitio web, como la sección de administración.

Conclusión

El archivo robots.txt es una herramienta fundamental para cualquier webmaster que busca mejorar su SEO. Comprender cómo funciona y cómo optimizarlo puede generar un impacto significativo en la indexación, el rastreo y la visibilidad de tu sitio web en los motores de búsqueda. Al seguir las mejores prácticas y las estrategias avanzadas, puedes aprovechar este archivo para que los bots de los motores de búsqueda encuentren y indexen las páginas más importantes de tu sitio web, mientras bloquean el acceso a secciones no deseadas.

Etiquetas:

- Robots.txt

- SEO

- Optimización de motores de búsqueda

- Rastreador web

- Indexación

- Agente de usuario

- Mapa del sitio

- Google Search Console

- Control de acceso

- Visibilidad del sitio web

La verdad es que no entiendo mucho de SEO, pero este articulo me ha ayudado a comprender mejor el robots.txt. 😊

El robots.txt es como un guardia de seguridad para tu sitio web. ¡Protege tu contenido de los robots malos! 💪

No entiendo nada de esto. ¿Me pueden explicar más sencillo? 😢

Buena informacion! Pero la verdad es que yo uso un plugin para manejar el robots.txt. No creo que sea necesario tanto trabajo manual. 😁

Yo nunca he usado el robots.txt, ¿de verdad es tan importante? 🤔

Este articulo es muy util! Me ha ayudado a comprender mejor el robots.txt y como optimizarlo para mi sitio web. ¡Gracias!

A mi me parece que esta guia es demasiado avanzada para un principiante como yo. ¿No hay algo más simple? 🤔

Yo creo que el robots.txt es una herramienta muy potente que no se debe usar a la ligera. ¡Hay que tener cuidado con lo que se bloquea! 😠

El robots.txt es como una puerta secreta que solo los robots especiales pueden abrir. ¡Misterioso! 🤫

Yo creo que el robots.txt no es tan importante como dicen. Es solo un pequeño archivo, no va a afectar mucho al SEO. 😉

Excelente guia, muy completa y con mucha información útil. ¡Recomiendo leerla con atención! 👌

El robots.txt es como una barrera para los robots. Solo los robots que tienen el permiso pueden pasar. ¡Que miedo! 😅